在 Day22 時我們有提到一個模型此模型叫做 ControlCom ,我對於其中的ControlCom非常感興趣,在上篇Survey論文中提到ControlCom為一個object-to-object模型。該模型的特色在於提供整體與局部的圖像融合。

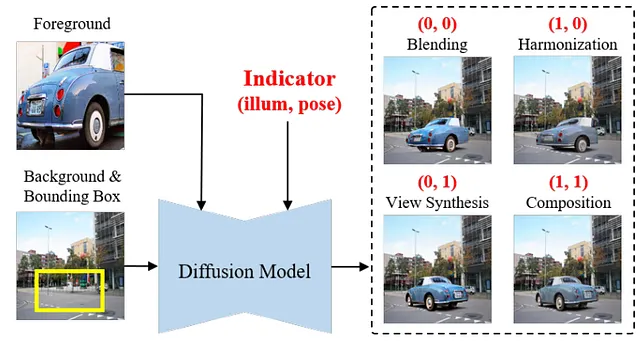

研究團隊將四項任務整合入一個 diffusion 模型,這四樣任務分別是:

以下針對這四種技術做一個基本的介紹:

主要用於將兩個或多個影像部分結合成一個無縫且協調的整體。而混合的關鍵是要確保在交界處的顏色和亮度能夠平滑過渡,從而達到自然的視覺效果。

調和技術用於調整一個或多個影像元素的風格、顏色、照明等,以使其更好地融入背景中。

視角合成是指從已有的影像中創建新視角的影像的技術。通過分析多個視角的影像,可以合成新的視點影像,提供更多的視角覆蓋。

組合技術涉及將多個圖像元素或層合成為一個統一的圖像。合不僅涉及物理位置的安排,也包括光線、陰影和視覺效果的匹配,以創建出引人入勝的最終產品。

而此模型的目標在於通過選擇前景的元素屬性(例如照明和姿勢)來實現圖像生成。而此模型採用自監督學習框架,能夠同時在上述任務中進行訓練,從而提高生成圖像的品質和控制度。

過去的方法大多是將圖像合成分解為多個任務,如圖像融合、圖像和諧化和視角合成。每個任務都旨在解決一個特定問題,但這些方法往往是繁瑣且不切實際的,因為需要依次應用多個模型。

近期的生成式圖像合成方法嘗試通過統一模型解決所有問題,這樣可以大大簡化合成流程。這些方法通常建立在預訓練的 diffusion 模型上,由於其在合成逼真圖像方面的出色能力,但它們仍面臨缺乏控制性和前景真實性低的問題。在控制性方面,diffusion 模型通常以一種不可控的方式調整前景的所有屬性(例如照明和姿態)。而在真實性方面,雖然生成的前景與輸入前景屬於相同的語義類別,但一些外觀和紋理細節的顯著變化,並未滿足圖像合成的要求。

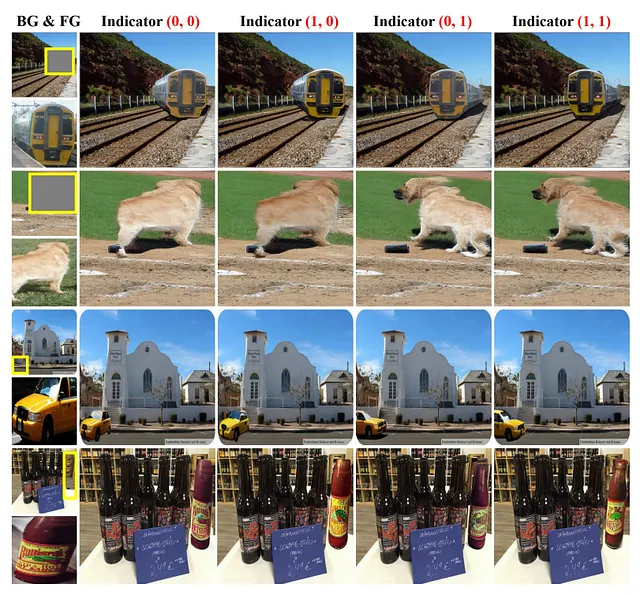

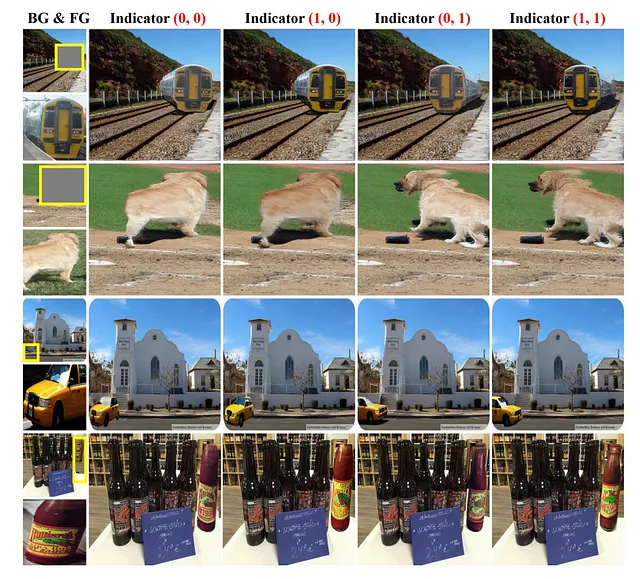

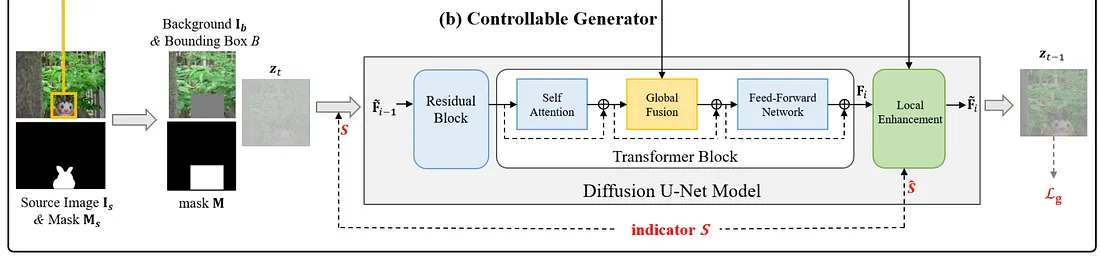

此模型的優勢在於提出了一種可控的圖像合成方法,通過條件擴散模型進行命名為 ControlCom,可以選擇性地調整部分前景屬性(即照明、姿態)。特別地,引入了一個二維指示向量來指示是否應更改前景的照明或姿態,並將該指示向量作為條件信息注入到擴散模型中。

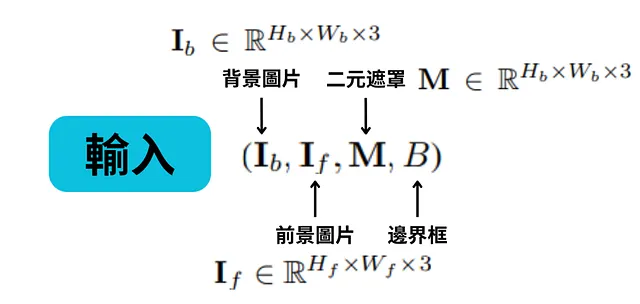

從上方的圖可以看到,此模型有四個輸入,分別是背景圖片、二元遮罩、前景圖片和邊界框,其中的 H 和 W 為圖像的長跟寬。

另外上方提到 ControlCom 的優勢在於可以選擇性地調整部分前景屬性(即照明、姿態),因此我們需要引入一個向量來表示是否應該改變照明與姿態。在此向量中,第一維度控制照明,第二維度控制姿態,其中值 0(分別為 1)表示維持(分別為改變)前景的相應屬性。有了這個指示器,我們可以選擇性地調整前景的照明和姿態,從而實現可控的圖像合成。

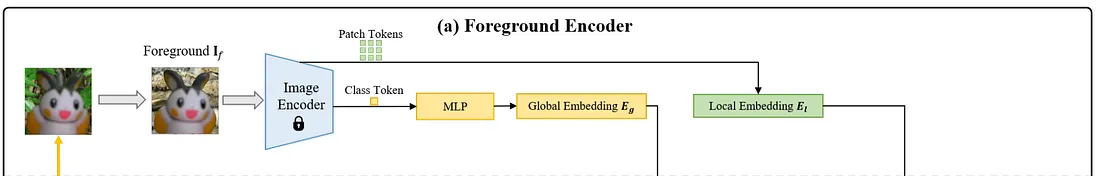

此模型利用 Stable-diffusion 模型為基礎去建立可控生成器。首先,下方是此模型的架構圖,接下來會分別進行解釋。

特徵提取

在前景編碼器中,研究團隊使用 CLIP 的 ViT-L/14 image encoder 來為圖片擷取特徵(224*224*3),而輸出資料為 s 257 個 tokens 以及 1024 維度,其中包括 1 個類別 token 和 256 個補丁 tokens。類別 token 負責攜帶高層次的語義信息,而補丁 tokens 則包含局部細節。

全局嵌入

利用由 CLIP 編碼器最深層(第 25 層)產生的類別 token,通過多層感知器(MLP)生成全局嵌入 Eg(維度為 768),用於表示整體語義結構。

Global embedding(全局嵌入):將整個圖像或圖像的主要部分轉換成一個緊湊的數字表示形式,通常稱為特徵向量。這種嵌入捕捉了圖像的全局性質,例如整體構造、主要物體的類別、或者整體風格等高層次的語義信息。

局部嵌入

為了豐富前景的細節信息,從較淺的層次(第 12 層)提取補丁 tokens 作為局部嵌入 El(維度為 256×1024)。這有助於捕捉前景的細節特徵,如外觀和紋理。

嵌入整合

將全局嵌入和局部嵌入整合進擴散模型的中間特徵中,生成具有豐富信息的表徵,從而使前景合成更加忠實和細緻。

首先在輸入的部分,為了使得能更輕鬆地適應任務,在模型中添加了背景圖像以及二進位遮罩以便於重建背景。另外前面提到了調整部分前景屬性(即照明、姿態)的向量會在接下來提到的 U-Net 輸入以及局部增強模組中使用。

接下來生成的部分分為兩階段:全局融合與局部增強。

✅全局融合

通過全局融合模組融合全局嵌入,先產生一個與背景場景一致的粗糙前景雛形。

利用 U-Net 的交叉注意力。為了應對圖像合成,我們用前景的全局嵌入 Eg 替換文字嵌入,這會通過交叉注意力注入到 U-Net 的每個 transformer 塊中的中間表徵。

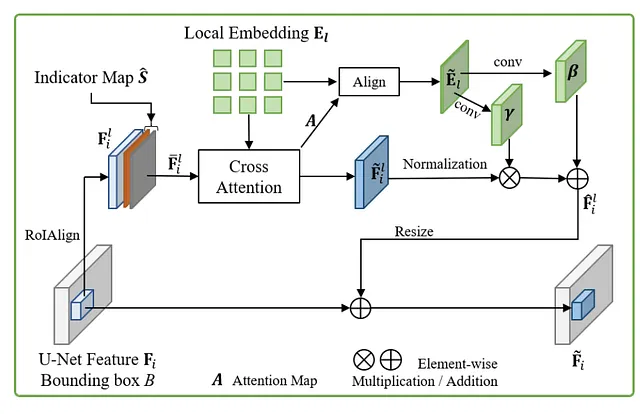

✅局部增強

為了合成合成圖像中的前景物體,通過局部增強模組融合局部嵌入提供的外觀和紋理細節,促進高保真合成圖像的生成。通過融合「局部嵌入」(El),「局部背景特徵」 (Fli) 能夠將「局部嵌入」(El)中的細微前景信息納入,生成與輸入更相似的前景物體。交叉注意力後,我們獲得「注意力圖」(A)和合成的「前景特徵圖」(F̃li)。

接著,為了進一步使用從「局部嵌入」(El) 構建的對齊的前景嵌入圖來調節合成的「前景特徵圖」(F̃li)。

「注意力圖」(A)成功捕捉了輸入前景與合成前景之間的空間對應。通過將 A 與「前景特徵圖」(El)相乘,並將這個結果轉換成 2D 空間結構,可以得到一張對齊的「前景嵌入圖」(Ẽl)。在這張圖中,每個像素位置都包含了相應的上下文信息,這有助於進一步處理「前景特徵」(F̃li)。

為了精確調節這些前景特徵,接著在 Ẽl 上進行卷積操作,產生空間感知的縮放和移位調節係數(由 convγ 和 convβ 卷積層產生)。這些調節係數用於標準化的「前景特徵」(F̃li),產生調整後的「輸出特徵」(F̂li),其形狀與「輸入特徵」(F̃li)相同。

最後,為了與「全局背景特徵」(Fi)融合,調整 F̂li 的尺寸,並將其添加到 Fi 中的特定區域,從而產生「增強特徵」(F̃i)。這些增強特徵包含了前景的外觀和紋理細節,進一步提高了合成圖像的真實感和質量。

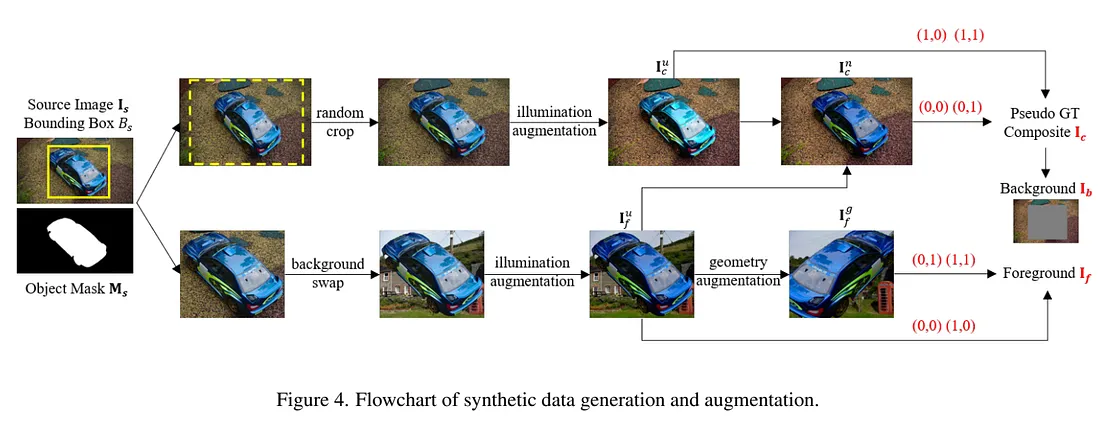

由於缺乏可以同時訓練四項任務的數據集,這篇論文提出了一個自監督學習框架,並結合了合成數據準備流程來學習這四個任務。

主要是從大規模數據集中收集合成訓練數據(Open Images)。首先過濾數據集,保留具有適當邊界框大小的物體(例如,框區域約為整個圖像面積的 2% 至 80%)。接著使用 SAM (Segment Anything) 為沒有遮罩的物體預測實例遮罩。之後,給定「原始圖像」(Is)和圖像中的「邊界框」(Bs),並裁剪包含物體的邊界框作為前景圖像,接著遮蔽邊界框區域來創建背景圖像。

使用隨機裁剪和照明增強來生成合成圖像的變體,稱為 Iuc。

接著,對於從同一來源圖像裁剪的前景圖像,首先進行背景替換,以將前景的非前景區域替換為其他背景,這可以防止模型學習到簡單的複製和粘貼。

然後我們依次對前景進行照明增強和幾何增強,分別生成 Iuf 和 Igf。這一過程干擾了前景的照明和姿態,模擬了前景與背景照明/姿態不一致的實際場景。最後,我們將 Iuc 中的前景物體替換為 Iuf 中的物體,得到 Inc。

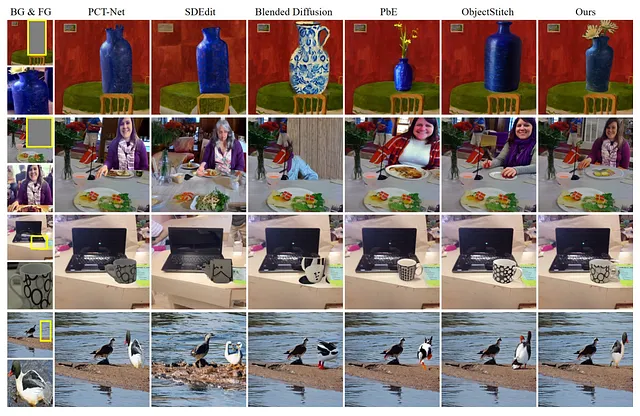

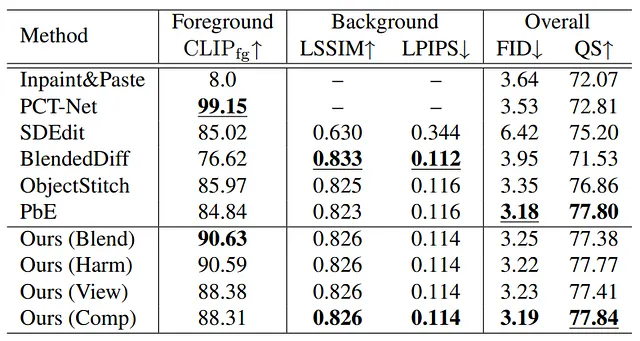

可以看到模型的表現相較於其他模型皆有更自然的表現。另外,下方是一些比較數據。

而我認為此模型最大的價值會在於它的可操控性。以往 AI 生圖最令人詬病的問題就是生成出來的結果與使用者心中的想法不同,而此模型提供的操控性我認為能夠很好地解決這類型的問題。